LLM (Large Language Models — большие языковые модели) — это категория моделей глубокого обучения, обученных на массивах данных. Благодаря этому модели способны понимать и генерировать естественный язык, а также другой контент, выполняя задачи по обработки, анализу и формированию ответов.. Современные LLM работают на архитектуре Transformer — нейросетевой структуре, разработанной для обработки последовательной информации, такой как текст. В основе лежит глубокое обучение: модель последовательно обрабатывает входные данные через слои искусственных нейронов, извлекая иерархические признаки и смысловые связи.

Модели обучают на корпусах из книг, сайтов, научных статей и других текстовых массивах. Модели ищут языковые закономерности на миллиардах текстовых примеров. Обучают в два этапа: предобучение — модель формирует представление о языке на корпусе; затем тонкая настройка (fine-tuning) — модель подстраивают под конкретные задачи на специализированных наборах данных. Применяют и адаптацию без изменения параметров — prompt-tuning. Подход задаёт текстовые инструкции (промпты) и направляет модель на решение конкретной задачи. Так LLM применяют в прикладных сценариях, а базовые функции и универсальность сохраняются.

Как работают LLMs?

Большие языковые модели (LLM) работают на основе нейронных сетей — вычислительных моделей из взаимосвязанных узлов, по структуре напоминающих нейроны в мозгу человека. Такая архитектура выполняет параллельную обработку сигналов; на её базе модель распознаёт шаблоны и осваивает сложные зависимости.

Ключевое отличие современных LLM — архитектура Transformer и механизм самовнимания (self-attention): модель оценивает вклад разных частей входных данных. Благодаря этому LLM предсказывают продолжение текста по принципу автодополнения. Модель использует миллиарды, а иногда и триллионы параметров, чтобы учитывать значение слов в контексте.

Со временем алгоритмы глубокого обучения предсказывают не только следующее слово, но и абзац, а иногда — следующую смысловую часть текста. Так LLM связывают структуру данных с бизнес-смыслом и создают текст под задачу.

Разновидности успешных ИИ-моделей построенных на архитектуре Transformer:

— Text—to—Text: генератор (GPT-тип): большая языковая модель читает запрос и дописывает текст слово за словом, опираясь на контекст. Примеры: ChatGPT, Claude.

— Text—to—Text: переводчик текста: модель понимает смысл исходной фразы и пошагово строит перевод на нужном языке. Примеры: DeepL.

— Speech—to—Text: распознавание речи: модель превращает звук в текст; языковая часть помогает правильно восстановить слова и пунктуацию. Примеры: Whisper.

— Speech—to—Speech: голосовой перевод в реальном времени: система из трёх блоков: распознавание речи; перевод; озвучка. LLM делает перевод, синтезатор проговаривает. Примеры: IVA Technologies (распознавание и синтез в голосовых решенияхж; перевод речи).

— Image-to-Text: мультимодальная модель (VLM): совместно обрабатывает изображение и текст; выполняет описания фото, ответы по скриншотам, интерпретацию схем и графиков. В основе — модуль компьютерного зрения, связанный с языковой моделью на архитектуре Transformer. Примеры: ChatGPT, Claude (Vision).

Для чего используются LLM?

LLM обучают выполнению задач. Распространённое применение — генеративный ИИ: по запросу модель создаёт текстовый ответ. Например, публичная LLM ChatGPT генерирует эссе, стихи и другие тексты по пользовательскому запросу.

Для обучения используют большие наборы данных, включая код на языках программирования. Некоторые LLM помогают программистам писать код. LLM создают функции по запросу или, получив часть кода, дописывают программу. LLM также применяют в областях:

• анализ тональности

• исследования ДНК

• поддержка клиентов

• чат-боты

• онлайн-поиск Примеры LLM: ChatGPT (OpenAI), GigaChat (Сбер), YandexGPT (Яндекс), Bing Chat (Microsoft). Примеры инструментов для «вайбкодинга» приведены в нашей статье.

Почему большие языковые модели (LLM) так важны

Большие языковые модели — LLM — уже работают в бизнесе. GPT-5 от OpenAI, GigaChat Сбера, Claude Anthropic и YandexGPT Яндекса меняют подход компаний к обработке естественного языка. Модели усиливают клиентский сервис: чат-боты работают круглосуточно; ускоряют создание и анализ контента; обрабатывают большие объёмы информации.

В работе с LLM используют промпт-инжиниринг: чёткие и структурные запросы задают цель и направляют модель к результату. Как генеративные модели, LLM создают тексты на основе языковых паттернов, которым научились. Качество и точность зависят от ясности инструкций. Чёткая формулировка промпта помогает раскрыть функционал модели и поддерживает точность.

LLM применяют в здравоохранении: обработка медицинских записей, интерпретация научных исследований и поддержка клинических решений. В финансах — анализ рынка, оценка рисков и выявление мошенничества. Юридические фирмы используют LLM для проверки документов, контрактов и правовых исследований. LLM становятся стратегическим инструментом трансформации бизнес-процессов.

Внутренние механизмы LLM: от текста к ответу

1. Токенизация: преобразование текста в числовой формат

Токенизация — первый этап обработки входного запроса — промпта. Токенизация переводит текст в формат, пригодный для машинной обработки. Поскольку языковые модели не работают с текстом напрямую, каждое слово или часть слова превращают в токен — минимальную смысловую единицу, в последствии назначают числовой идентификатор ID.

Токеном может быть слово целиком, часть слова, символ или словосочетание. Например, слово “tokenization” разбивают на [“token”, “ization”], если такого слова нет в словаре модели. Токенизатор выполняет это разбиение и назначает ID из словаря. Так, строку [“Controlled”, “Hall”, “uc”, “inations”] переводят в числовой массив [162001, 14346, 1734, 15628].

Модель различает токены по записи: слова в верхнем и нижнем регистре — «Кот» и «кот» — считает разными единицами. Токенизация не анализирует смысл: она стандартизирует входной текст и готовит токены для последующих математических операций внутри модели.

2. Эмбеддинги: преобразование токенов в векторные представления

После токенизации модель переходит к векторизации — формированию эмбеддингов. Числовые ID сами по себе ничего не значат, поэтому каждый токен превращают в вектор — массив фиксированной длины, например 768 или 4096 чисел. Вектор показывает позицию токена в многомерном смысловом пространстве.

В этом пространстве токены с близким значением лежат рядом. Например, векторы слов «король» и «монарх» близки, а «собака» — рядом с «щенок» и «пёс». Отношения между словами задают направления и смещения. Пример: вектор(«король») − вектор(«мужчина») + вектор(«женщина») ≈ вектор(«королева»).

Это не метафора, а результат математических операций. Модель учится на массивах данных и соотносит лингвистические переходы с геометрией эмбеддингов. Но это не означает понимания по-человечески: модель не осознаёт значения понятий и работает с числовыми связями между ними.

3. Механизм внимания (Attention): фокусировка на релевантном контексте

После преобразования токенов в векторное пространство модель оценивает, какие векторы учитывать при создании следующего токена. Это делает механизм внимания — компонент архитектуры трансформеров.

Данный механизм присваивает каждому токену вес в зависимости от его роли в контексте. Когда модель анализирует предложение, она вычисляет оценки внимания между текущим токеном и предыдущими, чтобы понять, какие элементы контекста важны для смысла фразы.

Пример: в предложении «Робот не поднял чемодан, потому что чемодан тяжёлый» при обработке слова «он» модель рассчитывает, к какому из предыдущих объектов — роботу или чемодану — относится местоимение. По оценкам внимания токен «чемодан» получает больший вес, потому что он логически и семантически связан с признаком «тяжёлый». Так работает динамическая фокусировка внимания.

При создании каждого нового токена модель пересматривает предыдущий текст и обновляет контекст ответа, затем определяет, какие токены нужны на каждом шаге.

4. Генерация ответа: авторегрессионное предсказание токенов

Финальный этап работы модели — создание текста. Создание идёт авторегрессионно: модель предсказывает следующий токен на основе текущей последовательности. Ответ строится по шагам, токен за токеном.

Каждое предсказание опирается на вероятностную оценку: модель пропускает текущую векторную матрицу через слои трансформера и на выходе отдаёт логиты — числовые оценки вероятностей для токенов словаря — 50 тысяч позиций. Затем модель применяет Softmax, превращает логиты в распределение вероятностей и выбирает наиболее вероятный токен; при необходимости учитывает настройки, например температуру.

Пример:

• «Это» — 15%

• «Механизм» — 12%

• «Внимание» — 9%

• «Валера» — 0,00001%

После выбора модель добавляет выбранный токен в конец контекста и повторяет цикл. Процесс продолжается, пока не встретится специальный токен завершения — END_OF_SEQUENCE.

Важно: модель не «придумывает» и не «сочиняет» ответ. Модель оценивает вероятность каждого следующего слова на основе предыдущего контекста. Каждое слово — результат расчёта, а не проявление сознания или творчества.

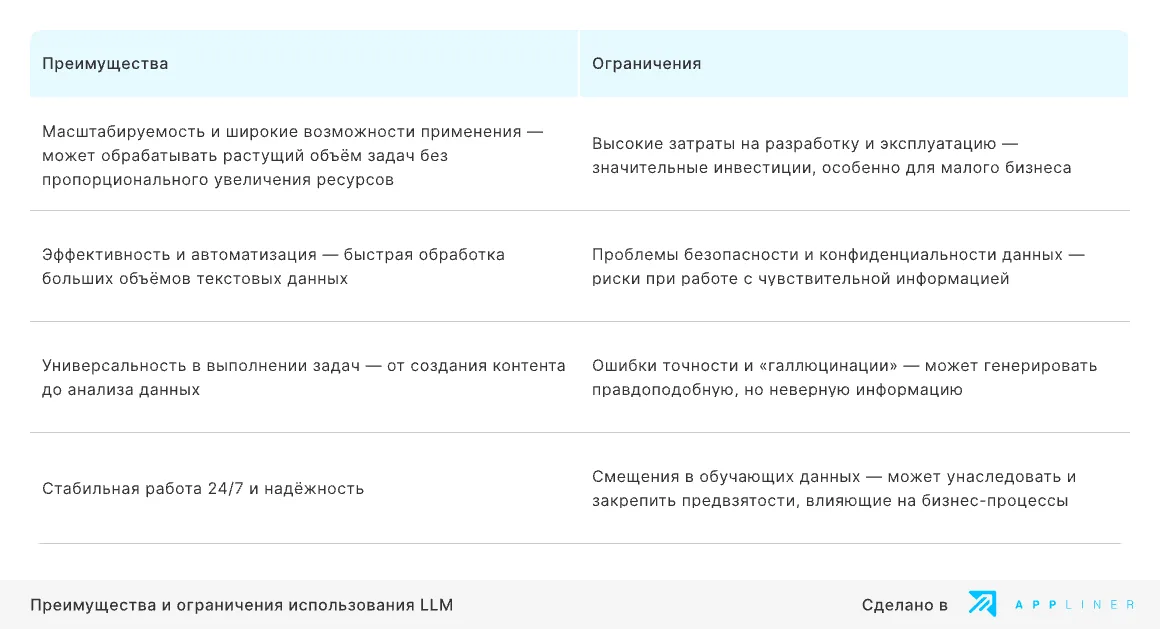

Преимущества и ограничения больших языковых моделей (LLM)

Преимущества

LLM предоставляют бизнесу ряд преимуществ, которые помогают трансформировать операционные процессы и создают конкурентные преимущества:

Масштабируемость и сценарии применения.

LLM обрабатывают больше задач без пропорционального роста затрат. Например, отдел клиентской поддержки вместе с чат-ботами на базе LLM разбирает тысячи обращений одновременно. Это повышает пропускную способность сервиса без увеличения штата.

Скорость обработки и автоматизация.

Модели быстро анализируют и обрабатывают большие объёмы текстов. Юридическая фирма использует LLM для анализа тысяч документов за часы вместо недель. Это снижает затраты на ручную проверку.

Контент и аналитика.

LLM применяют для создания контента и для аналитики. Например, маркетинговые отделы используют LLM для вариантов рекламных текстов, а исследовательские команды — для суммирования аналитических отчётов.

Режим работы и доступность.

Доступ к модели возможен 24/7. Это упрощает поддержку пользователей и работу службы поддержки.

Ограничения

При внедрении LLM учитывают ограничения:

Затраты на разработку и эксплуатацию.

Чтобы внедрить LLM, нужны инвестиции. Обучать собственную модель или пользоваться коммерческими API дорого, даже для малого и среднего бизнеса. Например, компания, которая обрабатывает 1 млн клиентских запросов в месяц через GPT-4, платит свыше $20 000, поэтому рентабельность считают заранее.

Риски для безопасности и конфиденциальности.

При работе с чувствительной информацией возможна утечка. Под угрозой — персональные данные клиентов, коммерческая тайна и внутренние стратегии. В здравоохранении соблюдают требования HIPAA при работе с данными пациентов.

Ошибки и недостоверные ответы.

LLM выдают правдоподобные, но неверные ответы — «галлюцинации». В сферах с высокими требованиями к точности такие ошибки приводят к убыткам и юридическим последствиям. В финансах неточные рекомендации или ошибки в интерпретации данных ведут к потерям.

Смещения в данных для обучения. Модели перенимают предвзятость корпуса и выдают несправедливые или дискриминационные результаты. Это влияет на подбор персонала, работу с клиентами и рыночную аналитику и повышает репутационные и юридические риски. В рекрутинге модели проявляют бессознательные предпочтения в оценке кандидатов.

Краткое резюме преимуществ и ограничений больших языковых моделей (LLM):

Применение больших языковых моделей (LLM) в бизнесе

Большие языковые модели — LLM — демонстрируют универсальность: использование LLM приносит пользу в отраслях и на этапах бизнес-процессов. На это указывает рост числа настраиваемых решений на LLM, которые ускоряют запуск и монетизацию генеративного ИИ.

С развитием технологий LLM выходят за рамки текстовых задач. После создания текста, аудио, изображений или видео из нескольких источников языковая модель интерпретирует результат в контексте бизнес-задач.

LLM расширяют применение генеративного ИИ и повышают предсказуемость, адаптивность и управляемость решений. Некоторые модели взаимодействуют с другими системами ИИ для сложных задач; компании автоматизируют процессы и помогают специалистам принимать решения.

Рост числа приложений на базе LLM расширяет сценарии использования ИИ в бизнесе.

Применение LLM для протоколирования встреч

Собрания и совещания — регулярная часть корпоративного общения. Итог встречи — не только решение, но и фиксация: кто что сказал, к каким выводам пришли, кто за что отвечает и в какие сроки. Протоколирование требует ресурсов и внимания к деталям, поэтому применяют искусственный интеллект на базе LLM.

Современные LLM берут на себя рутинный документооборот и общение: автоматически составляют структурированные протоколы во время встречи или после её завершения. Модель распознаёт сказанное, делит разговор на смысловые блоки — темы, решения, задачи, сроки — и собирает читаемую структуру. Технически модель обрабатывает стенограмму по шагам: разбивает запись на части, по каждой выделяет основные элементы, затем повторно анализирует результат, чтобы избежать потерь смысла на границах. Так модель сохраняет смысл и структуру даже при длинных обсуждениях.

Автоматическое протоколирование встреч на базе LLM— инструмент, который упрощает управление процессами, снижает нагрузку на команды и исключает потери при передаче информации. Такой подход сокращает время обсуждений и ускоряет переход к действиям, делает договорённости прозрачными и сохраняет полный контекст встречи. Решение масштабируют под размер команды и оно подходит там, где важны скорость, точность и единый контекст.

Создавайте приложения с искусственным интеллектом на платформе Appliner

С Appliner бизнес-пользователи быстро собирают функциональные приложения и подключают к существующим корпоративным системами — например, как CRM, ERP или к любым другим по REST API. Библиотека готовых блоков, конструктор интерфейсов и встроенные ИИ-ассистенты ускоряют сборку интерфейса, а модель данных, процедуры обработки хранимых данных и конструктор бизнес-процессов задают бизнес-логику — без единой строки кода.

Начните в облаке или разверните платформу на локальном сервере. Нужна помощь с внедрением ИИ в бизнес-процессы? Опишите задачу или запросите демо.

Оставить комментарий