1. Введение: Почему ИИ без контекста — не ИИ

«Даже самые продвинутые модели ограничены своей изоляцией от данных — они заперты в информационных силосах и легаси-системах».

— Anthropic о важности интеграции контекста

Сегодняшние большие языковые модели (LLM) невероятно умны, но находятся в вакууме. Как только им требуется информация вне их «замороженных» обучающих данных, начинаются проблемы. Чтобы ИИ-агенты действительно были полезны, им нужно получать актуальный контекст в нужный момент — будь то файлы, базы знаний, инструменты — и даже уметь совершать действия: обновлять документы, отправлять письма, запускать пайплайны.

С тех пор как OpenAI внедрила функцию function calling в 2023 году, становится всё более очевидным: чтобы по-настоящему раскрыть потенциал экосистемы агентов и инструментов, нужно нечто большее. Хотя сами модели становятся умнее, взаимодействие с внешними системами, данными и API остаётся разрозненным. Разработчики по-прежнему вынуждены вручную настраивать логику агентов под каждую отдельную систему.

Нужен единый стандарт — универсальный способ для моделей получать данные и вызывать действия. В своё время такими стандартами для Интернета стали протоколы вроде IP и HTTP — они задали общий язык для взаимодействия между машинами. Но у ИИ-моделей до сих пор нет такого протокола для подключения к данным и инструментам.

2. Что такое MCP?

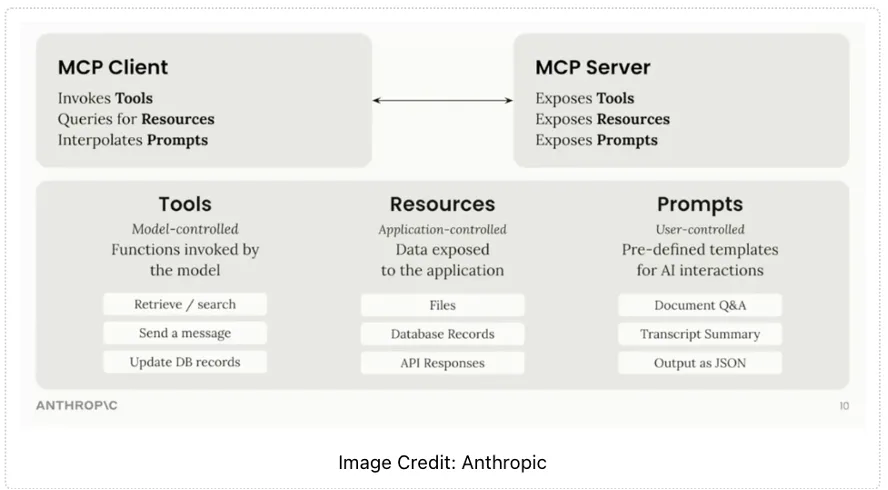

MCP (Model Context Protocol) — это открытый протокол, который позволяет системам передавать контекст языковым моделям ИИ в универсальном формате. С его помощью модель может подключаться к внешним инструментам, извлекать данные и выполнять действия.

Протокол описывает, как именно модель может находить, подключать и вызывать внешние ресурсы — например, делать запрос к базе данных, запускать заранее собранную процедуру или обращаться к таблице. Всё это работает по единым правилам и не зависит от конкретного сервиса.

Это расширяет возможности модели: она выходит за рамки своей обученности и может работать с реальными данными и системами — динамично, по запросу.

Технический обзор MCP

Протокол MCP использует формат сообщений JSON-RPC 2.0 (стандартизированный способ обмена данными между системами в виде JSON-запросов) для связи между тремя основными участниками:

- Хостами (Hosts) — это LLM-приложения (программы, использующие языковые модели), которые инициируют соединения;

- Клиентами (Clients) — это коннекторы внутри среды запуска, которые передают запросы к внешним сервисам;

- Серверами (Servers) — это внешние инструменты или сервисы, предоставляющие данные или действия (например, база данных, файловое хранилище, API).

Архитектура MCP частично вдохновлена Language Server Protocol (стандарт, с помощью которого редакторы кода подключают поддержку языков программирования). MCP решает аналогичную задачу, но в области ИИ: он задаёт единый способ подключения инструментов и контекста к ИИ-приложениям.

3. Почему MCP стал трендом в 2025 году

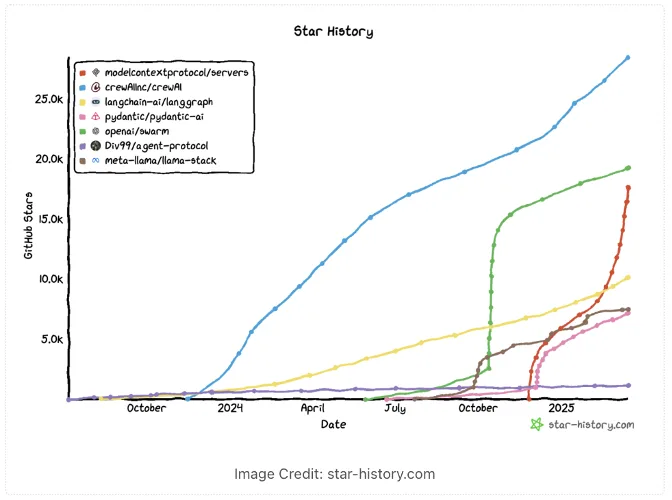

MCP впервые появился в открытом доступе в ноябре 2024 года — его опубликовала компания Anthropic. На старте это выглядело как интересная, но нишевая идея. Настоящий интерес к MCP начался только в начале 2025 года — и на то были веские причины.

ИИ-агенты и агентные пайплайны активно обсуждались с 2023 года, но у них был ключевой недостаток: слабая интеграция с реальными системами — базами данных, API, файлами. Основное внимание тогда уделяли самим моделям и техникам промт-инжиниринга. MCP предложил понятный стандарт, как подключать внешние источники данных и инструменты в работу ИИ — не через хаотичный код, а через формализованный протокол.

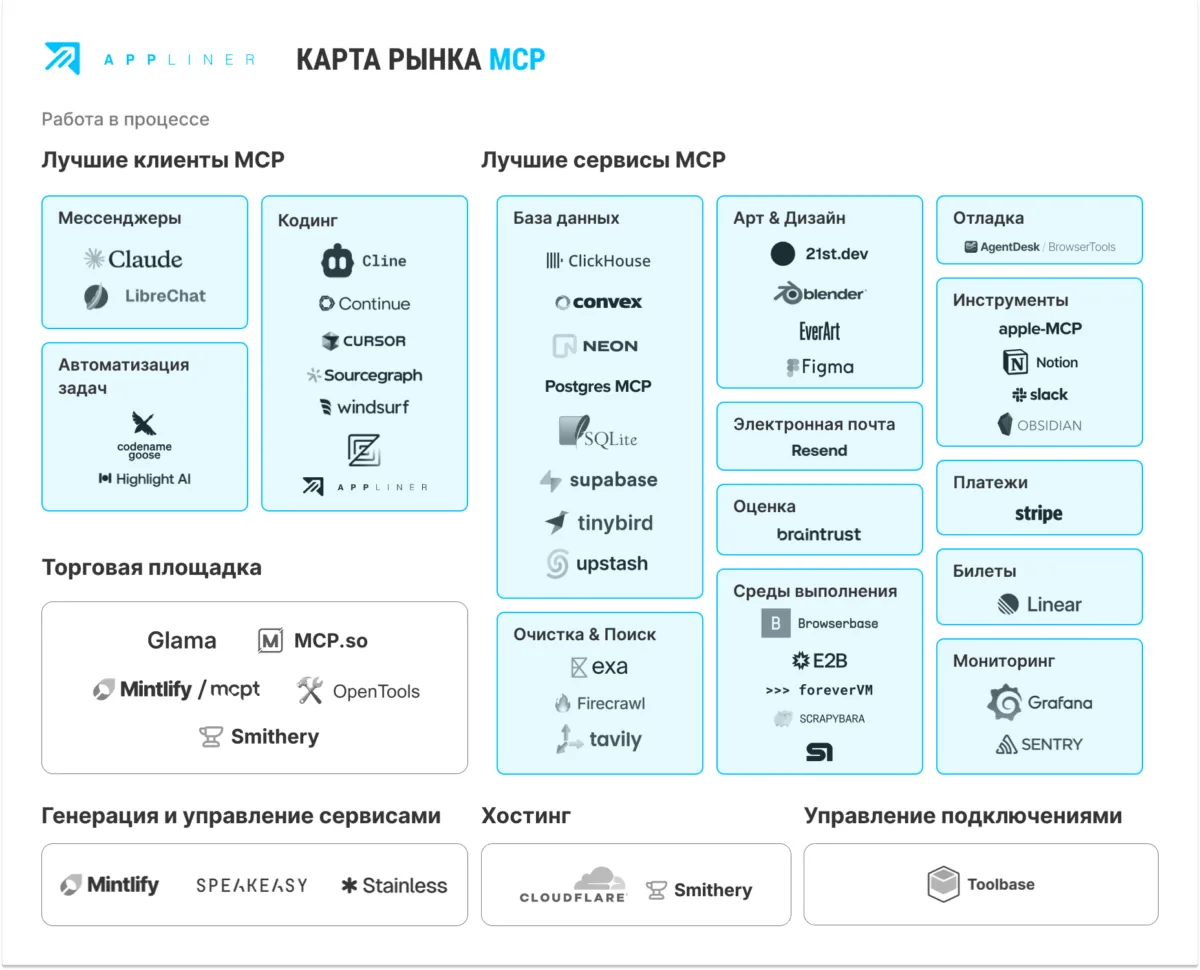

К февралю 2025 года сообщество создало уже больше 1000 MCP-серверов. MCP попал точно в запрос рынка: индустрия движется к ИИ, который умеет не только генерировать тексты, но и работать с контекстом, данными и инструментами. И для этого нужен именно такой стандарт.

В отличие от закрытых SDK и короткоживущих фреймворков, MCP — это открытый протокол. Его можно использовать с любой моделью: GPT-4, Claude, open-source LLM, а также с нейросетью, встроенной в Appliner. Это даёт возможность запускать действия прямо из среды, без привязки к какому-либо вендору. MCP-интеграцию можно разработать без разрешений и лицензий.

Anthropic продолжает развивать стандарт: публикует обновления, документацию и обучающие материалы. На AI Summit, например, одна из семинаров по MCP стал вирусным и дал мощный толчок к его внедрению во многих продуктах.

4. MCP в действии: типовые сценарии

С правильно настроенным набором MCP-серверов любой MCP-клиент становится точкой исполнения бизнес-логики. Подключённые серверы позволяют централизовать вызовы: от операций с данными — до триггеров внутри прикладных сценариев.

В Appliner это реализуется через множество вариантов подключения, например:

- Проблема «белого листа» возникает в момент первого запуска — когда отсутствует структура, от которой можно оттолкнуться.

- В Appliner предусмотрена возможность задать промт в формате пользовательской истории: на его основе ИИ-ассистент формирует прототип приложения под заданные требования.

- MCP может управлять этим процессом: каждый шаг — это конкретный вызов, который можно просмотреть, изменить параметры, сохранить как компонент или встроить в сквозной бизнес-процесс.

В этой конфигурации ИИ-ассистент берёт на себя управление no-code-сборкой. Все действия фиксируются, могут быть воспроизведены и включаются в целевую архитектуру приложения. Это позволяет перейти от идеи к рабочему прототипу за минуты — без ручной настройки и без потери управляемости.

MCP не просто соединяет — он трансформирует стартовое намерение в исполняемую структуру.

5. Как начать использовать MCP

MCP-клиент настраивается в среде Appliner. После подключения клиент автоматически распознаёт доступную функциональность: инструменты, ресурсы и prompt-шаблоны. Модель или агент получают возможность инициировать действия через MCP-сервер по мере необходимости.

6. MCP vs альтернативы: эволюция доступа к инструментам

До появления MCP интеграции с внешними системами приходилось реализовывать вручную — писать код под каждый API, плагин или фреймворк. MCP как раз меняет этот подход: вместо разработки с нуля интеграции можно просто настраивать — без необходимости писать программную логику для каждого случая. Например, чтобы подключить Google Drive и SQL-базу, нужно было отдельно интегрировать API Google, настроить доступ к базе данных, выполнить авторизацию и учесть особенности каждой системы.

Плагины (как в OpenAI) оказались неудобными: они работают только внутри одной платформы и требуют отдельной разработки под каждый сценарий. Фреймворки вроде LangChain упростили запуск ИИ-агентов и работу с инструментами, но всё равно требуют написания кода для каждой интеграции. А подход RAG ограничивается только чтением данных — он не даёт возможности действовать.

MCP предлагает единый способ подключения. ИИ-агент может сам находить нужные инструменты и вызывать их, без жёсткой привязки к платформе. Это не просто улучшение текущих решений — это принципиально другой подход.

7. Ограничения и вызовы MCP

Несмотря на очевидные преимущества, MCP остаётся относительно молодой технологией с рядом нерешённых ограничений. Большинство MCP-серверов, доступных сегодня, работают по принципу local-first (обработка запросов происходит локально на машине пользователя, без вынесения логики в облако) и рассчитаны на одного пользователя. Это объясняется тем, что текущая версия MCP поддерживает только соединения на основе SSE (Server-Sent Events — протокол односторонней передачи данных от сервера к клиенту) и простых команд. Распределённые сценарии с участием нескольких пользователей и ИИ-агентов пока находятся в стадии становления. Ранее Google представлял протокол A2A (agent-to-agent), ориентированный на взаимодействие между агентами, но широкого распространения он не получил.

По мере появления удалённых MCP-серверов особенно остро встаёт вопрос отладки и мониторинга. Разные клиенты реализуют поддержку протокола по-разному, что снижает стабильность работы серверов в продуктивной среде.

Кроме того, MCP пока не предоставляет встроенных средств для построения многошаговых процессов (воркфлоу) с возможностью сохранения состояния, приостановки, повторного запуска и возврата к промежуточным точкам. Подобные механизмы необходимо разрабатывать вручную — на уровне приложения.

8. Будущее MCP: куда всё движется

Появляются централизованные реестры MCP-серверов и единые точки подключения (.well-known/mcp) — они позволят ИИ-инструментам автоматически находить и использовать нужные функции без ручной настройки.

Разработчики уже создают маркетплейсы и платформы для размещения MCP-серверов: это упрощает поиск, установку и совместную работу с такими серверными компонентами. Возникает новый уровень стандартизации, где ИИ-агенты могут подключать нужные инструменты динамически — без жёсткой привязки.

Параллельно развиваются решения, которые позволяют автоматически генерировать MCP-серверы, размещать их в облаке и управлять соединениями. Это приближает рынок к полноценной экосистеме безопасного и масштабируемого взаимодействия между ИИ и инструментами. На платформе Appliner также готовится запуск собственного MCP-стека — с поддержкой внешних агентов, авторизации и подключением к внутренним компонентам. Анонс — скоро.

9. Заключение: MCP — не просто протокол

MCP быстро превращается в важный стандарт, который позволяет использовать ИИ не только как отдельную модель, но как инструмент, способный выполнять действия. Это протокол, через который ИИ получает доступ к реальным инструментам и системам.

Это не просто технологическая новинка — это фундамент для следующего поколения ИИ-продуктов. При правильной реализации MCP может стать основным способом подключения ИИ к внешним сервисам, приложениям и данным. Такой подход открывает путь к созданию автономных, мультимодальных и глубоко встроенных ИИ-систем.

На этом заканчивается наше руководство по применению MCP в работе с ИИ-инструментами. Следите за релизами, новостями и примерами внедрения — присоединяйтесь к сообществу Appliner в Telegram.

Оставить комментарий